30 июня прошел второй из цикла разговоров Российской экономической школы (РЭШ) о макроэкономике, поведенческих финансах, современных технологиях и образовании. В июне в Евросоюзе одобрили проект AI Act — первого закона об искусственном интеллекте (ИИ). Научный руководитель РЭШ Рубен Ениколопов и профессор Иван Стельмах обсудили вызовы, которые развитие ИИ ставит перед человечеством, и перспективы регулирования его полномасштабного внедрения в бизнесе и госуправлении. «Ъ» публикует текстовую версию беседы.

Екатерина Сивякова, автор научно-популярного портала РЭШ GURU: Сегодня будем говорить о том, как ошеломляющее развитие технологий искусственного интеллекта может изменить экономическую жизнь. Я бы предложила начать нашу беседу-форсайт так. Журналистов всегда интересует вопрос: а что же меняется, что же изменилось? Какие вызовы создает технологический прогресс в XXI веке, отличаются ли они от тех вызовов, которые создавали технологические прорывы прошлого? Меняется ли что-то сегодня?

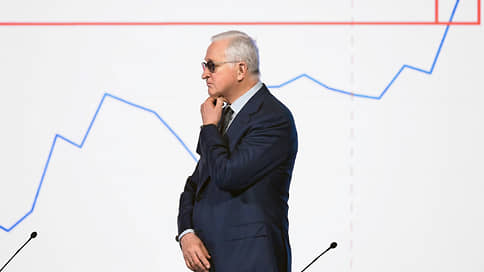

Рубен Ениколопов, профессор Университета Помпеу Фабра (Испания), научный руководитель РЭШ: Тут, как всегда с большими технологическими изменениями, важно понимать, что речь идет о действительно таких больших, фундаментальных изменениях в так называемых обобщенных технологиях, их по-разному называют, технологиях, которые меняют не одну конкретную индустрию, а меняют, собственно говоря, вообще организацию очень многих секторов. Это похоже на приход электричества в экономику, и в этом смысле есть много общего с теми технологическими крупными изменениями, которые происходили в прошлом, что их объединяет — это масштаб и то, что они в итоге практически все сферы человеческой деятельности охватывают.

«Просветительские дни» РЭШ–2023

Дискуссии о макроэкономике, личных финансах, EdTech и ИИ

То, что выделяет технологическую революцию, которую мы сейчас видим, мы живем в процессе,— это скорость прежде всего этих изменений, она гораздо быстрее, чем проходили раньше изменения, и охват. Если раньше все-таки в основном речь шла о физическом труде, заменяли ткачей и так далее, то сейчас технологические изменения дошли до святая святых, до когнитивных возможностей человека, и во многом эти технологии либо заменяют, либо дополняют именно когнитивную человеческую деятельность, и это уже очень сильное изменение. Поэтому есть элементы, которые похожи, есть элементы, которые нет.

Иван Стельмах, профессор РЭШ, занимается исследованиями на стыке машинного обучения, поведенческой экономики и теории игр: Для меня самое удивительное то, что текущая техническая революция начала угрожать «белым воротничкам», исторически считалось, что весь прогресс где-то там, в «синих воротничках», а мы тут хорошо живем, и ничего не будет. А вот сейчас это не так, я провел весну в Германии, в Макса Планка (Институт физики Общества Макса Планка.— “Ъ”), там кампус Amazon, и оттуда приходят новости, что они перестают нанимать стажеров на некоторые проекты, потому что стажерские работы уже выполняет ChatGPT достаточно хорошо, дешевле чуть-чуть больше времени потратить на сode кeview, но отказаться от найма большого количества стажеров. Я сам вошел в AI (artificial intelligence, искусственный интеллект.— “Ъ”) и стал профессором, будучи стажером в «Яндексе» в 2016 году, и если представить себе, что «Яндекс» тогда бы не нанимал стажеров, наверное, это как-то бы это отразилось на моей карьере. Поэтому это звучит немножко угрожающе, хотя я тут очень оптимистичен, на самом деле не вижу принципиальных угроз. Пока.

— «Стажеры ведь потом могут вырасти в крепких специалистов, когнитивные способности которых будут выше машины. Разве нет недальновидности в том, что их перестанут нанимать из-за искусственного интеллекта»?

Иван Стельмах: Да, конечно, есть. Я не думаю, что их прям перестанут нанимать. Это просто был конкретный кейс на конкретном проекте, где их перестали брать. Стажер просто должен научиться пользоваться этой машинкой как можно раньше. То есть ChatGPT и другие инструменты станут просто одним из инструментариев разработчика, может, будем не писать код, а говорить машине, какой код писать. Конечно, стажеры никуда не уйдут.

А вторая тема мне тоже кажется очень интересной, это такая сложность предсказания того, что случится завтра. ChatGPT возник буквально в прошлом декабре, и можно было ожидать прогресса в этом направлении, но такого качественного скачка, что у нас появится инструмент, с которым можно действительно общаться в чате и с трудом верить, что это не человек, а алгоритм, какая-то статистическая модель, которая нам там отвечает, это удивительно даже для экспертов. Я себя считаю достаточно образованным и знаю людей, которые более глубоко, чем я, в эту область погружены, и они не все ожидали, что будет что-то такое. Поэтому непонятно, что случится завтра. Этот прогресс не так обоснован научными открытиями, какими-нибудь теоремами, фундаментальными доказательствами, это сейчас очень инженерная штука, и ребята во всем мире что-то делают, чтобы стать еще лучше, и неизвестно, что будет дальше. Так что немножко беспокойно, да.

— В массовом дискурсе автоматизация и ее влияние на рынок труда обсуждается довольно сильно и уже достаточно долгое время. Но, конечно, развитие технологий ИИ подбросило дров в огонь этой дискуссии. Давайте продолжим таким терминологическим вопросом: по мнению экспертов ОЭСР, искусственный интеллект — это технология, которая может улучшить благосостояние людей, способствовать устойчивому экономическому развитию, увеличивать производительность. А как бы прозвучало ваше определение, их довольно много сегодня, что такое вообще ИИ и в каких областях развитие этих технологий наиболее заметно?

Иван Стельмах: Я подготовил такую небольшую метафору, мне кажется, что искусственный интеллект, или AI,— это просто умная Excel-табличка. Представьте себе, что вы открыли Excel-файл, вбили в первую колоночку там длину комнаты, во вторую колоночку ширину комнаты, а в третью колоночку — площадь. Вы сами руками сможете сделать формулу, которая из длины и ширины может посчитать площадь, просто пишете в Excel: перемножьте А1 на B1 — это будет площадь. Вот что такое AI? Это на самом деле автоматический подбор формулы. Мы задаем ему несколько строчек, в первой колонке длина комнаты, во второй ширина, в третьей — площадь, и AI сам находит закономерность и сам научается заполнять третью колоночку по первым двум.

В этом смысле это определение немножко разочаровывающее. Такая крутая технология, а на самом деле просто подбор формулы в Excel. Но в этом его, мне кажется, магия и то, что меня абсолютно поражает. Мы можем работать с формулами, которые берут пять цифр и выдают одну, а AI может работать с такими закономерностями, из одного текста, неструктурированного, абсолютно длинного, с ошибками и опечатками, выдает нам другой текст, который, может быть, продолжает его, отвечает на вопросы. То есть та мощь формул, которыми он может оперировать, превосходит нашу намного. С одной стороны, ничего прикольного, просто формула в Excel, с другой стороны, это не просто формула в Excel, а такая формула, которая всем формулам формула.

— Как все, оказывается, просто. Вы уже упоминали этот критерий всеобъемлющего развития технологий ИИ, как бы ваше определение звучало, какой для вас акцент был бы наиболее важен?

Рубен Ениколопов: Мне нравится такое определение, даже книжка так называется — «Машина предсказаний». Эта аналогия для меня как-то проясняет, чем занимаются практически все технологии ИИ: на основании имеющихся данных неимоверного размера, которые сейчас действительно они обрабатывают, машина делает предсказания — про прошлое, настоящее, будущее. Надо понимать, что очень часто мы пытаемся предсказать не будущее, а прошлое и настоящее — вот именно этим эта машина и занимается. Это ее сила и это ее слабость.

Сила заключается в том, что технологии ИИ действительно научились обрабатывать неимоверные массивы данных с потрясающей быстротой и делают очень хорошие предсказания, которые во многом лучше, чем те предсказания, которые делают люди, особенно в таких ситуациях, когда нет очень существенных изменений в той системе, которую вы пытаетесь предсказывать, потому что в принципе это умная машина, но у нее нет такой обобщающей модели. Пока что те технологии, которые существуют в ИИ, очень сильно привязаны к историческим данным, тем данным, которые у них есть.

— Они на них учатся.

Рубен Ениколопов: Но это их ограничение, они пока не умеют выходить за границы того, на чем они обучились. Условно говоря, я просто испорчен физическим образованием (физфак МГУ.— “Ъ”), для меня эта технология была бы как машина, которая может очень четко вам посчитать силу тяготения на Земле, потому что все данные с Земли, и точно сказать: если я брошу камень с такой-то высоты, он упадет с такой-то скоростью. Но если спросить, что будет происходить на Марсе или на Юпитере, поскольку она там не была и у нее нет данных относительно того, как бросают камушки на Юпитере, то эта машина, скорее всего, даст сбой. И это в отличие от человека, у которого сила и слабость на самом деле в том, что он строит обобщающие модели, которые не всегда правильные — и в этом слабость.

Иван Стельмах: Я тоже силу тяготения на других планетах так сходу не скажу.

Рубен Ениколопов: Вот, а есть люди, которые могут. Я, наверное, правда тоже сейчас уже подрастерял, мне надо будет долго считать формулу, но помню какие-то основные вещи.

— Я хотела бы эту вводную часть завершить вопросом, который из ваших реплик следует. Если мы про книжки говорим, то будущее с ИИ — это утопия или антиутопия?

Рубен Ениколопов: Понимаете, ИИ — это инструмент, такой же, как молоток. Можете им гвозди забивать, а можете черепа крушить. Мне кажется, когда выходим на философскую дискуссию, мы немного пытаемся подменить проблемы, связанные с ИИ, проблемами, связанными с человечеством, которое использует этот ИИ. Искусственный интеллект — это очень мощный инструмент. Как его использовать? У искусственного интеллекта какая часть интеллекта, по сути, отсутствует? Мотивация: цели он сам себе не ставит. И в принципе по-хорошему решение он не принимает, решение принимает человек, который его запрограммировал. Поэтому вот помимо предсказаний, что на следующем уровне? Казалось бы, чем человек отличается, у человека есть еще одна ступень: на основании предсказаний человек принимает решения, что делать.

Вам ИИ может сказать, что, знаете, у вас вероятность рака такая-то, это действительно делают сейчас, замечательно делает ИИ, он научился; не по всем, но по некоторым: на основании фотографий, с вероятностью такой-то у вас такой-то тип рака. А дальше что? Что теперь делать? Вам назначать химиотерапию, не назначать? Как это лечить — консервативно, не консервативно, операцию? И это гораздо более сложный вопрос, потому что у него нет правильного ответа для разных людей. У разных людей, в зависимости от их собственных предпочтений, их ситуации жизненной и так далее, у них те издержки и те возможности, которые дает такое-то лечение или такое-то, они абсолютно разные. И машина вам не может сказать, потому что это вы должны принять решение, что для вас важнее: возможность победить рак, например, или все те издержки, которые будут связаны с лечением. И принятие решений на основании предсказаний, это, уже по сути, человеческая вещь, пока что это не доверяют ИИ, слава те господи. Мне кажется, эта вещь — та грань, которую, наверное, не стоило бы переходить.

И поэтому, когда рисуют картины антиутопий всяких страшных, «Черное зеркало» и так далее, идет сбой в том, кто виноват. Все говорят, что виноват ИИ; в основном, если посмотреть на все эти предсказания, там какой-то человек что-то не то сделал с этим инструментом. Поэтому мне кажется, что все-таки утопия это или антиутопия — это абсолютно зависит только от людей, не от машин. Но вероятность того, что мы попадем из нашего обыденного мира либо в антиутопию, либо в утопию, она возросла просто потому, что возможности этого инструмента выросли. Так же как ядерную реакцию придумали: вы можете ее использовать для того, чтобы у вас был доступ к электричеству в неописуемых количествах, которые невозможно было себе представить до этого, или можете взорвать весь мир. Ядерная реакция и ядра тут ни при чем.

Иван Стельмах: Я тоже не знаю, утопия или антиутопия, главное, чтобы она не была скучной книгой, и, я думаю, есть большая вероятность, что она будет нескучной. Мы очень много увидели таких научных прорывов, даже ChatGPT по сути научный прорыв, еще не продуктовый. Мы еще не увидели, как он может поменять продукты и наш образ жизни, если он хорошо к нам внедрится. Поэтому я надеюсь, это будет Книга открытий, а в какую сторону пойдет — да, действительно, это совсем не зависит от AI. К сожалению, ответ такой: никаких машин, которые yfc захватят, я пока не вижу, поэтому, я думаю, это книга о глупости и уме человека.

— Давайте попробуем посмотреть на существующую повестку со стороны государства и вот этой связки человек, машины и ограничения. В Европе довольно давно и горячо обсуждают законопроект об ИИ, так называемый AI Act, этот документ, с одной стороны, основан на принципах уже существующего закона ЕС о защите персональных данных и в случае принятия будет иметь экстерриториальный характер, а с другой — эти принципы в какой-то степени развивает. Его основное содержание — это квалификация рисков, которые связаны с использованием технологий ИИ. Если законопроект будет принят, а это ожидается уже в 2023 году, то он станет первым в мире законом, регулирующим технологии, созданные при помощи ИИ. Что подтолкнуло к этому регуляторов, которые довольно быстро этот процесс организуют?

Рубен Ениколопов: Регуляторов, как и любых политиков, подталкивает давление со стороны людей и избирателей. Поэтому что их подтолкнуло, достаточно понятно. Ну откройте газеты, почитайте, как сейчас обсуждают и насколько есть поляризованные мнения в отношении того, что нам несет ИИ, как с точки зрения тех выгод, которые он очевидно, приносит, так и с точки зрения потенциальных опасностей, которые тоже, может быть, становятся более очевидными, хоть и далеко не все. Это очень интересная книга, в которой мы читаем и пишем одновременно, и куда она заведет — мы пока не понимаем. Поэтому очень сложно писать какие-то законодательные акты, которые регулируют возможные последствия потенциальной какой-то технологии, когда вы не знаете эту технологию и не понимаете ее. Именно поэтому акт этот пишется с большим трудом и обсуждается. И он такой — достаточно рамочный. Именно потому, что очень тяжело понять, слишком быстро все меняется.

Но запрос у общества на то, чтобы были какие-то введены ограничения и чтобы это все-таки прекратило быть полным Диким Западом, где нет никакого регулирования, очевидно, сформулирован, и на это отвечают те регуляторы, у которых есть возможность это сделать. Можно сидеть, обсуждать, беспокоиться по поводу ИИ на острове Фиджи, но вряд ли от этого вы сможете что-то сделать. В современном мире есть только две юрисдикции, которые действительно обладают достаточной политической мощью, чтобы повлиять на то, как ведут себя технологические компании, прежде всего мы говорим о технологических гигантах, это США и Европа. США в принципе по своей политической структуре с регулированием скорее с запаздыванием обычно реагируют на все, но это политический выбор. А европейские политики известны как более инициативные, скажем, и раньше начинают, поэтому не случайно, что этот акт обсуждается именно в ЕС, потому что и запрос есть, и возможности надавить на технологических гигантов.

Иван Стельмах: Мне кажется, в какой-то мере обществом и политиками движет страх. Технология эта развивается очень быстро, и действительно непонятно, что будет завтра, поэтому хорошо иметь какие-то возможности ее регулирования, а они в Европейском союзе занимают довольно долгое время, даже принятие рамочного закона, поэтому иметь его очевидно полезно. Успех с GDPR (General Data Protection Regulation.— “Ъ”), прошлой большой инициативы, которая сильно повлияла на ИИ, кстати, тоже, на его развитие, позволяет надеяться, что и здесь будет успех.

Параллельно город Нью-Йорк на удивление работает над законом, который предполагает аудит алгоритмов, которые используются в найме. И масштаб вроде куда меньше, но они обсуждают это достаточно долго и сталкиваются на самом деле с теми же проблемами, с которыми столкнется Европа, скорее всего, в будущем.

— Следующий вопрос связан с качеством этого аудита. С какими трудностями регуляторы могут столкнуться при мониторинге этих рисков и каких компетенций от них потребует реализация этого процесса? И как вообще на практике может выглядеть регулирование технологий, которые, с одной стороны, уже разработаны, а с другой — постоянно самообучаются?

Иван Стельмах: Здесь может быть несколько подходов к самому вопросу регулирования. И в европейском акте одна из удачных идей — это попытка пойти не от технологий, а от сфер и разделить разные use case, то есть области применения технологии, на разные риски. Это куда проще, и можно сделать, даже не разбираясь в самих технологиях искусственного интеллекта. Понятно, что распознавание лиц, биометрия может быть более опасной, чем какой-нибудь спам-фильтр. Это понятно людям, тут не нужно быть экспертом в AI, чтобы понять, что одна область более опасная, и больше ограничить в ней использование технологий.

А вот второй путь — это именно попытка сделать аудит или регулировать работу конкретного алгоритма в конкретном кейсе, и вот это, мне кажется, очень сложная задача, для которой часто инструментария нет. Как пример: мы все оперируем понятием честности, мы, как люди, все его знаем, и, если при приеме на работу девушку не взяли, потому что она девушка, мы говорим, что это нечестно. И это понятие честности на самом деле очень сложное и очень плохо формализуется. Перевести в математику, что значит для любого алгоритма «быть честным», без потери смысла практически невозможно.

И здесь, я считаю, есть большая недоработка комьюнити AI, машинного обучения и математиков, потому что эта область развивалась супернеправильно, и все, что там делалось,— это попытка придумать новые определения честности, которые противоречат друг другу, не работают, их невозможно внедрить на практике, и сейчас у регулятора нет реальных инструментов, чтобы аудировать алгоритм на уровне алгоритма.

— Безусловно, вопрос предвзятости алгоритмов существует, и это огромная тема. По сути, есть такой индустриальный подход, секторальный, и есть прецедентный подход, на уровне кейсов когда мы смотрим и потом пробуем это все масштабировать, эти практики как-то перенести.

Иван Стельмах: Размен между ними понятен. Если мы регулируем всю индустрию, весь use case, то мы ограничиваем прогресс, если мы запрещаем использовать AI-алгоритм в какой-то области, то мы не даем этой области взять у него все хорошее. С одной стороны, это плохо. Но с другой стороны, так как мы не умеем хорошо проверять алгоритм на уровне конкретного алгоритма и решений, которые принимаются на основе этого алгоритма, то, к сожалению, я думаю, что к сожалению, здесь приходится ограничивать таким секторальным способом, чтобы избежать недопониманий и возможности манипуляций.

Потому что математика и теория открывают для компаний огромную поляну для манипуляций, если регулятор введет какой-то численный критерий и скажет: мы применим эту формулу, чтобы проверить ваш алгоритм, большие компании, маленькие компании, любой математик сможет найти 15 путей, как это все обойти, поэтому приходится таким секторальным, может быть, чересчур широким, но более надежным способом подходить к регулированию.

Рубен Ениколопов: Я абсолютно согласен, что это во многом проблема комьюнити, людей прежде всего в компьютерных науках, что этой проблеме не уделялось достаточно внимания, и поэтому приходится не то что начинать с нуля, но по сути практически начинать с нуля. Мне кажется, что разговор о том, насколько честный — нечестный, потенциально опасный — не опасный алгоритм, он немножко отстал от того, как устроены алгоритмы, потому что пока что дискуссия идет так, как будто действительно это написано в виде алгоритма. Если так — то так, если так — то так… Мы можем посмотреть на дерево решений и понять, правильно ли решение, если каждое-то из решений правильное — вот такой аудит.

Сейчас надо понимать, что сами методы машинного обучения и ИИ — это черный ящик, это все признают. Они самообучающиеся, при глубоком обучении, сколько у вас там, что оно там, о чем оно думало, когда принимало это решение, уже никто не может понять, включая всех людей, которые разработали изначальный алгоритм, в который заложено самообучение. Эти алгоритмы запускаются, дальше они сами куда-то бегут и куда-то прибегают. Куда они прибежали, уже сложно понять, и на этом этапе есть несколько вещей. Во-первых, то, над чем предстоит еще поработать, это систематизация научных подходов к тому, как это происходит, такая работа патологоанатома, что ли, вот у вас уже есть алгоритм, проверьте, он вообще нормальный? У него есть какие-то проблемы в том, как он работает? И это если мы просто заморозим алгоритм, не дадим ему самообучаться. Даже это уже большая проблема. Это первое.

И второе, я категорически против и считаю, что будет очень много вреда, если будут формальные методы, формализованные методы определения — этот алгоритм хороший, этот плохой. Мы уже вошли в область этики, законодательства и так далее, которые очень плохо формализуются. Если вы увидите, как люди принимают решения — они часто между собой не согласны. Сейчас абсолютно фундаментальные решения, которые принимают, например, суды — вот в Америке посмотрите, решения, которые меняют миллионы человеческих жизней, они принимают эти решения 4:3 — из семи человек трое согласились, четверо не согласились, что уже говорит о том, что это не простое решение. Как алгоритмизировать такие вещи — я не вижу вообще. Это во-первых.

Исследование с участием профессора РЭШ того, как соблюдение религиозных ритуалов и традиций влияет на качество правосудия,— Mehmood, Seror & L. Chen. «Ramadan fasting increases leniency in judges from Pakistan and India», Nature Human Behaviour

Во-вторых, действительно, чем более формализованы критерии, тем легче ими манипулировать. А искусственный интеллект просто гениально манипулирует любыми ограничениями. Вы можете попробовать использовать искусственный интеллект на стороне регулятора, чтобы ограничить искусственный интеллект со стороны разработчиков, но я вас уверяю, что регуляторы всегда проиграют.

— Интересно, как ChatGPT написал бы тот же самый AI Act, что бы он предложил в качестве регулирующих норм?

Рубен Ениколопов: Вряд ли мы хотим оказаться в ситуации, когда на судебном заседании у вас один алгоритм выступает на стороне обвинителя, а другой — на стороне защиты. А мы так сидим и смотрим, что там происходит. Поэтому мне кажется, что человеческий компонент в оценке того, что хорошо, а что плохо, абсолютно фундаментален. Только человек может определить, что хорошо, что плохо.

Я изначально всегда — благо я испорчен тем, что занимаюсь политической экономикой,— очень с большим подозрением отношусь, когда регуляторы или политики решают изменить нашу жизнь к лучшему. Обычно мы приходим к ситуации, когда лекарства оказываются хуже болезни. И поэтому я с замиранием сердца ожидал этот проект, про акт говорят очень давно, и пока что, мне кажется, он даже лучше, чем GDPR — к GDPR у меня очень много претензий именно потому, что он очень формальный.

И меня, скорее, радует то, что обсуждаемый акт по искусственному интеллекту гораздо менее формализованный, и поэтому его не так легко обходить. Он действительно вводит категории рисков по тому, где применяется, а дальше он так уклончиво очень говорит: вот вы там применяете это при найме на работу. Это повышенный риск, вы должны получить разрешение на этот вариант. У кого? У людей. И вот это, мне кажется, правильный подход. Как это организовать? Опять же, это очень рамочно, мы еще не знаем, как это организовать, но то, что там во главу угла ставится все-таки аудит со стороны людей, а не других алгоритмов, мне кажется фундаментально абсолютно важнейшей характеристикой этого акта.

— В марте сооснователь Apple Стив Возняк, глава Twitter Илон Маск, который, кстати говоря, был одним из инвесторов OpenAI, компании—создателя ChatGPT, и другие представители международного сообщества подписали открытое письмо, в котором призвали как минимум на полгода приостановить обучение систем, созданных с помощью технологий ИИ. Под письмом уже более 33 тыс. подписей. Аргументационная линия письма выглядит следующим образом: системы ИИ нужно разрабатывать только тогда, когда есть уверенность в том, что эффекты будут положительными, а риски управляемыми.

Поскольку сейчас такой уверенности нет, нужно этот процесс разработки поставить на паузу, привлечь внешних экспертов и вместе с ними составить протокол безопасности для дальнейшего проектирования и разработок. При этом роль правительств в этом письме тоже очень подробно описана. Предлагается, что если процесс разработки быстро не остановить, то правительства должны внести аж мораторий на нее.

Кроме того, политики могут создать новые регуляторные органы, улучшить инструменты аудита, финансировать исследования безопасности ИИ а также обеспечить ресурсами институты, которые помогут преодолеть экономические и политические потрясения, которые вызовет развитие искусственного интеллекта. Эта инициатива как раз пример саморегулирования. А что может подтолкнуть бизнес к саморегулированию кроме угрозы регулирования?

Рубен Ениколопов: Ну, во-первых, письмо, мне кажется, полная утопия, и оно важно с той точки зрения, что привлекает внимание к проблеме, а сам основной посыл — за все хорошее против всего плохого, он очень далек от реальной жизни.

Иван Стельмах: И с помощью внешних экспертов каких-то, которые придут…

Рубен Ениколопов: Кто эти внешние эксперты, вообще не понятно, потому что, в принципе, ну а кто еще? Кто у нас эксперты, которые не вовлечены уже в эти технологии? И мне бы хотелось верить, что они имеют в виду профессоров, но я в этом не уверен.

— Узок круг участников этой дискуссии, честно говоря.

Рубен Ениколопов: Разумеется. Опять же, по аналогии, вот мы можем устроить публичные обсуждения технологии ядерного синтеза, ну давайте, вперед. Сколько людей вообще понимает, как он работает? Более того, это как раз хороший пример, потому что очень много людей обсуждают проблемы ядерного синтеза, я даже со своими рудиментарными знаниями — я на этом никогда не специализировался — понимаю, что большинство из того, что говорят эти люди, полная чушь. Потому что все хотят быть экспертами, а в принципе понимают они так же, как футбольные эксперты в футболе. Мало понимают.

Поэтому у меня вопрос, что такое эти внешние эксперты, вызывает большое непонимание, кто вообще имелся в виду, хотя в той части, в которой призывается больше исследований, я только за. Я, как исследователь, только за: и больше денег, и больше ресурсов, и мы все исследуем. Причем основной ресурс — это доступ к данным, и это отдельная вещь, которая обсуждалась; на данный момент, насколько я знаю, я ее как-то не увидел в конечном законе, а именно более четкие требования к транспарентности, к прозрачности и к открытию информации, данных о том, как работает, на основании каких данных, как работает алгоритм — публично. Понятное дело, что есть коммерческая тайна, но прозрачность алгоритмов вызывает вопрос.

Возвращаясь все-таки к вопросу о том, что будет давить на бизнес. Нельзя рассчитывать на то, что бизнес будет исходить из общественного блага. Так не работает. Отдельные руководители бизнеса могут, но тогда это убивает всегда бизнес-возможность вести себя более рационально, скажем, а на самом деле более цинично и зарабатывать больше денег, и в итоге хороший бизнес будет вытеснен прагматичным бизнесом.

На бизнес могут с точки зрения общественного блага воздействовать две вещи. Первая — это прям жесткое регулирование, о котором мы сейчас говорим. Вторая, тоже важная,— общественное мнение. Потому что такие вещи, как бойкот, например, определенных компаний, определенных продуктов,— есть научные исследования, которые показывают, что бойкоты работают. И сейчас, условно говоря, если вы даже в какой-то стране разрешите работорговлю, ну, вам будет сложно продавать свои товары, если будет известно, что вы в это вовлечены.

Поэтому мы видим, что общественное давление даже сейчас уже работает. Поскольку иногда в конкретной, например, области, с алгоритмами это сложнее, потому что люди не понимают, что происходит, но люди уже начали понимать что-то про приватность, про доступ к данным. И видно, как поменялось отношение людей к этому, прежде всего самих пользователей: 15 лет назад никто не обращал на это внимания, а сейчас очень сильно обращают на это внимание. И защита, например, данных пользователей, и нераспространение, непродажа их другим компаниям становится конкурентным преимуществом. Мой продукт может быть лучше, потому что он гарантирует людям то, что их данные не будут распространяться. И сейчас это один пример, потому что вот там общество дозрело до понимания, что сохранность моих личных данных — это важная вещь.

Я бы ожидал, что общественные нормы будут меняться, и многие из тех практик, которые сейчас используются цифровыми компаниями, алгоритмами, которые считаются нормальными — по манипулированию, например, людьми, они будут считаться не комильфо, и давление будет именно со стороны клиентов. Другого пути нет, на самом деле: либо вас регулируют, либо вы теряете деньги, когда плохо себя ведете. Вот это действует.

— Безусловно, ценностный бойкот, эти кейсы мы видим все больше и больше, и, разумеется, вот эта cancel culture в этом же понимании, судя по всему, будет только развиваться.

Иван Стельмах: Я тоже считаю, что общественное мнение, общественное давление куда более действенный инструмент, чем даже регуляторы. С медлительностью регуляторов и со скоростью, с которой мысль распространяется в Twitter, тут сложно сравнивать. Но интересно, что у алгоритмов потихоньку-потихоньку появляется, появилось, очевидно, достаточно сильное влияние на само это общественное мнение. И сейчас уже непонятно — платформы, которые исторически лишь предоставляли контент, типа Instagram, Facebook (принадлежат Meta, деятельность которой признана экстремистской и запрещена в РФ.— “Ъ”), Twitter, то есть площадка, где каждый мог создать контент, то вот алгоритмы модерации и рекомендации стирают грань между просто предоставлением контента и курированием, созданием этого контента.

Интересно просто, что у некоторых компаний больше инструментов влияния на это общественное мнение, и здесь, возможно, страх других игроков перед возникновением какого-то нового крупного игрока в области, потому что сейчас область AI достаточно фрагментированная. Есть несколько крупных корпораций, которые владеют по сути этой технологией, и мы живем более-менее в таком равновесии между ними, они там конкурируют, но живут, в общем, мирно. Появление нового игрока, который, может быть, с какой-то суперинновационной темой зайдет на рынок, может заставить больших игроков задуматься о регулировании просто для того, чтобы не потерять свои позиции. Но мне кажется, здесь чуда не произойдет, и бизнес всегда будет рационален.

— В таком случае, какие стимулы можно предложить бизнесу со стороны правительств, чтобы им было выгодно учитывать социальные последствия развития технологий искусственного интеллекта?

— На ум приходит на самом деле какой-то аналог ESG-индекса, по сути, вся эта экологическая повестка и попытка сделать бизнес более ответственным в этой области, создает индексы, которые, с одной стороны, наказывают отстающих, с другой стороны, поощряют передовых ребят. Что-то в этой области можно сделать. Но я опасаюсь, что такой индекс или лейбл, что вот вы хороший, а другие еще лучше, опять же открывает возможность для маркетинга, плейсмента, лоббирования, а не сутевого изменения. Тут, мне кажется, кнут и пряник, они как бы вместе. Если общество бойкотирует одного, то, значит, оно поддерживает другого, поэтому тут отделить одно от другого достаточно сложно.

Рубен Ениколопов: Я вот, опять же, с большой опаской отношусь к правительствам, поэтому сказать, что правительство должно что-то сделать, чтобы увеличить общественное давление? У нас проблемы с тем, чтобы обществу хватило достаточно сил давить на правительство, а чтобы правительство еще как бы давало возможность давить на другие компании, это утопия. Общество само должно это делать. Мы почему-то все время придерживаемся подхода: что должно для нас сделать правительство. В общем, наше счастье в наших руках. Это вопрос самоорганизации, я гораздо больше верю в некоммерческий сектор: все институты гражданского общества с точки зрения давления на большой бизнес и на политиков гораздо эффективнее.

Все, что мы сейчас видим: и digital act, и так далее,— это ответ на общественное давление. И эффективность давления в этой сфере связана с теми же самыми институтами гражданского общества, демократическими нормами, когда свобода слова, собраний, и организации, которые поддерживают любое общественное давление по любой проблеме. В данный момент — искусственного интеллекта. Это может быть любая другая проблема. Гражданское общество должно быть сильным.

Иван (Стельмах.— “Ъ”) поднял очень важную тему, которую я считаю, абсолютно фундаментальной: когда вводится регулирование? Обычно, когда инкумбент, уже существующие крупные фирмы укрепились, боятся конкуренции и вводят такие ограничения, которые как бы должны быть, чтобы обезопасить общество, но на самом деле одно из их критических свойств заключается в том, что они делают так, чтобы новые игроки не вошли на этот рынок. У меня претензии к GDPR во многом из-за этого. Маленькой компании соответствовать всем нормам GDPR практически невозможно, надо содержать большой штат юристов, чтобы удовлетворить всем запросам европейских бюрократов. И это преимущество, конечно, есть у крупных компаний.

Я боюсь, что именно поэтому эти законы так и проходят, что нет активного лоббирования со стороны крупных фирм, и им, может, даже во многом некоторые из этих законов выгодны, опять же есть масса примеров в политической экономике из предыдущих технологий, когда уже существующие фирмы готовы поддерживать какие-то законы, от которых как бы они страдают, главное, чтобы конкуренты страдали еще больше. И тогда они будут полностью на стороне законодателей.

— Давайте как раз про конкуренцию и монополизацию поговорим. Как вам кажется, тот факт, что у части рынка концентрируются эти разработки и компетенции по созданию инноваций, а другая часть рынка может не успевать за драматической скоростью технологических изменений и не иметь, может быть, доступа к этим технологиям непосредственного, как это в целом может повлиять на рынок и как бизнес будет принимать решения в таких условиях? Изменится ли инструментарий планирования, прогнозирования рисков?

Иван Стельмах: Можно во многом критиковать комьюнити, что оно не думало об этике, о чем-то еще, но с точки зрения открытости на самом деле AI-комьюнити — супероткрытое, я думаю, это самая открытая область исследования, и даже бизнесовая, потому что те исследования, которые публикуем мы, они, как правило, открыты для всех — в свободном доступе, любой человек их может прочитать. Как правило, хорошим тоном является публикация кода, то есть все разработки, трансформеры, на которых сейчас основан ChatGPT, они были отданы наружу со всем исходным кодом, любой их может переиспользовать.

А с точки зрения инфраструктуры — понятно, что у Google, у Microsoft, у больших компаний есть огромное преимущество, но они же на ней зарабатывают. Облачные решения сейчас дают доступ к передовым вычислительным ресурсам, их достаточно недорого можно купить, каждый исследователь может себе их купить. Тут сложность с тем, что как исследователь я, допустим, могу получить доступ к облаку того же Google, а как российской компании, например, мне может быть намного сложнее.

И вот на уровне страны риск, мне кажется, действительно есть, потому что производителей оборудования, которое нужно для тренировки нейросетей и разработки алгоритмов, мало, и они хорошо контролируют свои потоки, поэтому тут может быть замедление просто за счет серьезного удорожания процесса тренировки нейросетей. Потому что нейросети — это такие штуки, которые нужно всегда кормить данными, всегда держать их в форме, в хорошем спортзале, а для этого им нужно много мощностей и вычислительных ресурсов.

Здесь я для страны вижу риск, а для всего комьюнити вряд ли — пока оно было супероткрытым. OpenAI — это, наверное, единственный пример компании, которая сильно защищает свои разработки и не выдает их наружу, но умельцы всегда находят аналоги. Вы не поверите, но GPT-3, технология, которую сделал OpenAI, есть в открытом доступе, люди его пересобрали на каких-то там отрывочных данных, а сейчас люди делают GPT-4, поэтому тут пока все хорошо. В будущем действительно может быть монополизация, но сейчас все хорошо, а я предпочитаю не думать о плохом.

— Как вам кажется, как сильно- и быстрорастущий рынок может реагировать на возможное сдерживание с помощью правовых инструментов? Если говорить о цифрах, Bloomberg посчитало, что в прошлом году прибыль рынка генеративного искусственного интеллекта составила $40 млрд, но при этом аналитики предполагают, что в десятилетнем горизонте, к 2032 году, доходы могут вырасти драматически — до $1,3 трлн. При этом будет расти спрос и на инфраструктуру. То есть у нас есть супер быстро растущий рынок, есть интенция его зарегулировать, как рынок будет на это реагировать?

Рубен Ениколопов: Здесь сразу несколько вопросов. Давайте начнем с конца. Как будет реагировать рынок? Рынок всегда будет сопротивляться. Поэтому его и приходится регулировать. Если бы рынку было выгодно, и он уже что-то делал, то никому не надо было это регулировать. Регуляция для того и существует, чтобы заставить компании делать, и не отдельные компании, действительно, тут надо говорить про рынок, потому что очень много связано не с тем, как хорошо или как плохо себя ведет отдельная компания, а это такой популяционный, скажем так, эффект. Поэтому, мне кажется, тут, как будет реагировать рынок, очевидно. Вопрос в том, куда его направить.

С точки зрения монополизации я чуть менее оптимистичен, чем Иван (Стельмах.— “Ъ”), по другой причине — очень открытый и действительно очень конкурентный первый шаг в разработке алгоритмов, вот эта научная деятельность и так далее, дальше все эти алгоритмы собираются, и на их основе делается уже какая-то машинка, которая потом производит какой-то продукт и где-то применяется. И если первая фаза действительно очень прозрачна, потому что во многом это комьюнити живет по нормам академического, а не бизнесового общества, следующий шаг уже живет по законам рынка, а вовсе не по законам научных организаций. И это гораздо более закрыто. Вот применение алгоритмов даже уже всем известных гораздо более закрыто, и дьявол обычно именно там.

Если мы посмотрим то, что мне ближе, поскольку я изучаю социальные сети, базовый алгоритм, который использует, допустим, Facebook, Netflix, чтобы подсовывать вам фильмы и так далее, они действительно чистые, прозрачные, светлые, все о них знают. Как они их применяют и для чего, чтобы заставить вас сидеть в этих сетях или не отрываться от сериала очередного на Netflix? Вот это уже гораздо менее прозрачно, и здесь, конечно, добиться от Facebook, как он использует алгоритм, я знаю, я пытался — нет, так не работает.

Поэтому я хотел уточнить, я в какой-то момент уже сказал, что мне кажется, что регулирование прозрачности — это важный аспект, который я не вижу пока в AI Act, это было как раз не об алгоритмах, а о применении этих алгоритмов. И вот там, мне кажется, очень большие проблемы могут возникнуть.

Опять же, все путают старые алгоритмы, когда дерево решений каких-нибудь, с этими самообучающимися алгоритмами. Потому что в итоге то, как ведет себя искусственный интеллект,— это функция того, какой был алгоритм на входе, и тех данных, на которых он обучился, и того фидбэка, который получает этот алгоритм с точки зрения того, удалось — не удалось достичь тех целей, которые поставил создатель этого алгоритма. И вот все следующие стадии очень сильно зависят от данных, и там огромное конкурентное преимущество у компаний, которые имеют доступ к большому количеству данных. Именно поэтому это приводит к тому, что в экономике называется отдача от масштаба, она там суперэкспоненциальная.

В тех технологиях, которые до сих пор применялись, тоже есть отдача от масштаба, именно там обычно возникают монополии, которые становятся естественными монополиями, но вот здесь он проявляется в полной мере. И здесь просто по фундаментальным причинам все подталкивает к созданию монополий уже на стадии применения алгоритма. На стадии разработок может быть какой-то гениальный человек, который еще в школе учится, придумает алгоритм, который завоюет мир. Надо это понимать: алгоритм придумать — это очень демократичная вещь, а вот применять его в бизнесе — это, наоборот, супернедемократичная вещь, где очень большая отдача масштаба, и это подталкивает к созданию монополий.

Я думаю, что частично тот общественный резонанс, который получают применения искусственного интеллекта, во многом еще связан с тем, что применяется это прежде всего технологическими гигантами, которые монополизировали уже мировой рынок. И с точки зрения монополизации применения ИИ это действительно очень большая проблема.

— Если мы из глобального масштаба переходим все-таки, меняем немножко локацию, сможет ли Россия поспевать за этим развитием технологическим, сможет ли она занять свое место в индустрии искусственного интеллекта? Мы видим, что параллельно в условиях технологической полуизоляции, в которой сейчас оказалась страна, российские крупные технологические компании развивают свои модели генеративного искусственного интеллекта. У «Сбера» это GigaChat, у «Яндекса» это YandexGPT. Как вам кажется, что будет происходить с отечественным рынком?

Иван Стельмах: С точки зрения пользователя, уровень технологического развития компании определяется же не столько экспертизой именно в узкой области AI, какие крутые алгоритмы у них есть, а в умении завернуть их в продукт. И вот тут до сегодняшнего дня у России не было проблем, все продукты, которые наши технологические компании делают — «Яндекс», «Тинькофф», Ozon,— они все прекрасны. Я пользовался схожими продуктами во многих странах мира, и они часто хуже. Те же «Google Карты» не вызывали у меня таких позитивных впечатлений в Нью-Йорке, как «Яндекс Карты» в Москве. Поэтому, мне кажется, имидж технологическим компаниям удастся поддерживать, и они действительно будут продолжать оставаться такими же крутыми. Будет ли им сложнее? Я думаю, сложнее будет, но смекалочка куда-нибудь да вывезет, все будет хорошо в конце концов.

Рубен Ениколопов: Сложнее будет, тут я согласен. Ситуация поменялась так, что доступ к человеческому капиталу сократился у этих компаний, рынки сократились, я повтор: очень важен масштаб в применении этих продуктов. Как только вы лишаетесь доступа ко многим зарубежным рынкам, вы будете за это платить, это плохая новость. А хорошая новость заключается в том, что даже рынок России — это опять же не Фиджи. Там есть критическая масса, которой достаточно того, чтобы развивать многие эти направления, и с точки зрения человеческого капитала как бы тоже Россия талантами богата, даже если он сократится, критическая масса, мне кажется, есть, и поэтому это будет продолжаться, хуже и медленнее, чем в другой ситуации, но пациент скорее жив, чем мертв

Иван Стельмах: И здесь вот именно открытость на уровне алгоритмов и технологий очень важна, потому что, по сути, компания может взять алгоритм, на который другие компании потратили много времени, интеллектуального ресурса и денег, и уже на основе него сделать продукт, сократив то отставание, которое было бы у них, если бы эти алгоритмы не были публичными. Поэтому это нам продолжает играть на руку. Я надеюсь, что область останется такой же открытой, какой она была, и наши компании смогут подхватывать и хорошо внедрять.

— Хочется задать вопрос со стороны общества. Социолог Элвин Тоффлер во второй половине XX века предложил концепцию футурошока, с помощью которого он описал процесс принятия обществом значительных изменений, связанных с развитием новых технологий. В России, кстати говоря, стала очень популярна эта концепция в период осмысления посткоммунистической трансформации социальной, в первую очередь экономической.

В начале этого процесса людям необходимо смириться, писал Тоффлер, с потерей прошлого и принять тот факт, что так, как раньше, больше не будет, и только после этого возможно освоить новую реальность и найти в ней свое место. Поэтому в периоды технологической и социальной трансформации обычно актуализируется вечная альтернатива — свобода или безопасность. Как вам кажется, что выберет общество на этот раз?

Иван Стельмах: Я думаю, сейчас у общества есть куда более животрепещущие аспекты, с которыми нужно смириться, чтобы понять, что так, как раньше, больше уже не будет. Тут технологическая революция не самая болезненная штука, с этим мы смиримся и сживемся куда легче, чем с другими вещами.

Рубен Ениколопов: Знаете, вопрос, на какой стадии, правда, отрицание мы точно прошли, злость, видимо, тоже, сейчас где-то в состоянии торга, вполне возможно, потом наступит еще депрессия, прежде чем наступит принятие всего этого. В этом есть очень большая доля правды. Возвращаясь ко всем этим негативным аспектам, самыми действенными являются общественные изменения и изменения общественных норм того, как в новой реальности надо жить, чтобы она была не такой болезненной.

Проблема этой технологической революции, скажем так, действительно похожа на то, что произошло с Советским Союзом,— скорость. Другие технологические большие революции и самые большие социальные изменения, они готовятся, общество к ним зреет, зреет, и потом там начинается это бурление. Когда происходят слишком быстрые изменения, общество не успевает за тем, что происходит. Мне кажется, вот это мы наблюдаем: общество не успевает за происходящими изменениями, это видно и на стадии норм.

То, что сейчас обсуждаются возможные негативные последствия ИИ на рынке труда, то, что вытесняется огромное количество людей, которых непонятно, чем занять, это тоже переходный период, то же самое что с ткачами, луддитами, как было раньше. Вопрос в скорости, у вас должно быть достаточно времени, чтобы этих людей переобучить, перенаправить в другие сферы деятельности. Проблема, что делать с этими «белыми воротничками», если их завтра всех ChatGPT вытеснит. Тогда с очень большой скоростью надо их переобучить на что-то более общественно полезное, чего не умеет ChatGPT делать. Поэтому я думаю, что болезненность восприятия текущей ситуации во многом связана именно со скоростью происходящих изменений, и это вносит дискомфорт в общество, который вполне понятен.

— Да, действительно, мы про скорость сегодня много говорили. Это, кажется, лейтмотив нашей дискуссии. Вопрос про рынок труда: есть ли исследования, статистика или личные наблюдения по поводу того, в каких профессиях, связанных с финансами и экономикой, машинное обучение станет необходимой частью скиллсета для входа в нее?

Иван Стельмах: Мне кажется, что сейчас машинное обучение — это такой ключ ко входу в любую профессию без знания профессии. Мы недавно на одном из курсов приглашали спикеров из разных индустрий, из банковской сферы, из трейдинга, из ритейла и спрашивали у них, что еще нужно знать кроме ML (machine learning, машинное обучение.— “Ъ”), чтобы применять ML в вашей области? И поразительно часто ответы были: да я сам в принципе ничего не знаю из финансов, из ритейла, я просто ML выучил, пришел, как-то разобрался с проблемой, и все поехало. Людей, которые знали ML, было мало, их не хватало, и они легко находили себе работу в любых отраслях.

Но с тем, как AI глубже внедряется в нашу жизнь и происходит такая социальная адаптация, появится спрос на чуть более широких специалистов, которые не просто умеют именно разработать алгоритм, натренировать модель на какую-то метрику и отдать ее кому-то другому для внедрения, а на end-to-end (сквозных.— “Ъ”) специалистов, которые смогут не только разработать, но и внедрить это самостоятельно, потому что этот гэп между тем, кто разрабатывает и кто внедряет, приводит к печальным последствиям, когда один человек разработал, не зная зачем, а другой применил, не зная что, и в итоге не получилось ничего хорошего. И чем больше в критические области мы проникаем, тем это важнее. Мне кажется, что ML станет новой математикой, и все будут на первом курсе изучать линейную алгебру и машинное обучение.

— Это, знаете, как в начале 90-х в России входом в любую профессию было знание иностранного языка, английского, вот примерно то же самое, кажется, происходит сейчас. Развитие ИИ может проходить неравномерно в странах с разным уровнем экономики, будет ли это недостатком в исследовании данной технологии?

Рубен Ениколопов: Это может привести к росту неравенства между странами. Я думаю, что это имелось в виду. Здесь, понимаете, двоякий ответ, с одной стороны, да, это может привести к росту неравенства с точки зрения фирм, которые генерят все эти новые инструменты. Но с точки зрения их применения вполне возможно, что именно потому, что это очень общая технология, легко распространяемая, это даже лучше, чем электричество. Электричество придумали в развитых странах, и пока оно там дошло до развивающихся стран, и начали его применять. Все эти алгоритмы очень быстро переносятся, у них нет географических барьеров, и поэтому разработанные действительно в тех странах, у которых есть преимущество — в развитых странах, алгоритмы очень легко переносятся в другие страны.

Будет неравенство с точки зрения производства этих всех продуктов, основанных на искусственном интеллекте. Но с точки зрения их применения в конкретных областях скорее наоборот, границы не так важны, и во всяком случае по сравнению с другими технологическими революциями здесь мы будем видеть не такую большую разницу. То есть вопрос, какой из эффектов доминирует — вы больше хотите производить эти продукты или потреблять. Вот ответ разный.

— Есть ли какие-то кейсы, гипотезы использования ИИ на рынке криптовалют?

Иван Стельмах: Я думаю, хедж-фонды давно используют всякие алгоритмы для высокочастотной торговли. Это у меня такой очевидный ответ. Я сам не эксперт в криптовалюте, недавно летел в Америке с одним стартапером, вот вопрос о регуляции: он мне пытался рассказать за два часа перелета, какой стартап он делает. Там хайповые слова все были, но у меня они в какую-то картинку не сложились. И как его зарегулировать, непонятно, чем человек занимается. Деньги поднимает на рынке?

— Мы весь сегодняшний разговор занимаемся… вот у нас попытка сложить хоть какую-то картинку, знаете, каждый из нас какой-то пазлик туда вставляет.

Иван Стельмах: Я думаю, что добавление слов AI и «крипто» в один стартап повышает вероятность фандинга. Пока еще повышает. Поэтому стоит применять.

— Какие есть возможности внедрения искусственного интеллекта в EdTech и классическом образовании? Как это повлияет на бизнес-процессы в случае с EdTech-стартапами и как это воздействует на классические образовательные организации?

Рубен Ениколопов: Мне кажется, что потенциал гигантский. Просто потому, что, будучи школьником, студентом, я помню, как я страдал от того, что нас всех всегда стригли под одну гребенку и никакой индивидуализации образования не происходило, хотя мы прекрасно все знаем, что именно в этом ключ к успеху. Все люди уникальны, и то, как они обучаются, чем больше там есть индивидуализации, тем лучше. И мне кажется, что вот здесь огромные перспективы, несмотря на то что образование — то, что попадает в высокорискованное применение искусственного интеллекта по новому закону. И правильно, я думаю, потому что искалечить жизнь… ладно, взрослые, но, когда до детей доходит, надо очень аккуратно к этому подходить. Но перспективы, с моей точки зрения, они огромные. Именно с точки зрения индивидуализации образования.

EdTech — что он меняет в образовании

Онлайн-дискуссия в рамках «Просветительских дней» РЭШ

— Пользуетесь ли вы ChatGPT?

Рубен Ениколопов: О, я попробовал. Мне не понравилось. Но мои соавторы уже пользуются и объясняют, что это проблема не в ChatGPT, а во мне, вы просто как бы не умеете их готовить. Поэтому я вот жду, когда мне наконец-то объяснят, или я сам научусь, видимо, методом итерации, как им правильно пользоваться. Я, конечно, вижу очень хорошее применение: то, что сейчас не умеющие программировать люди могут писать код на Python, потому что они знают, что они хотят, а как это сделать, это не моя проблема, пусть ChatGPT подскажет. Это демократизует вход на рынок анализа данных, причем неимоверным образом. Что, мне кажется, очень удачно.

Писать статьи научные, слава тебе господи ChatGPT еще не научился, и потому я спокоен, что я не стану пока безработным. Пока, но кто знает, что будет в будущем? И вот в этой области пока что он мне не очень помогает. Но моим студентам, я просто вижу, как он действительно очень сильно помогает. Это позиционируется как угроза, а с моей точки зрения, наоборот, это очень, очень положительное влияние.

— Мы тестировали ChatGPT, задавали ему вопросы про научные знания, попросили его решить несколько задачек по микроэкономике. С задачками он справился неплохо, а вот с анализом научного знания вообще не справился. Хочу дать вам возможность сказать заключительное слово.

Иван Стельмах: Классно подискутировали, мне понравилось.

Рубен Ениколопов: Мы по верхам задели почти все идеи и опасности, связанные с искусственным интеллектом, а дальше можно уже копать, как они используют наши данные, чтобы нами манипулировать, какой это, возможно, окажет эффект на рынке труда, и кто должен бояться, а кто, наоборот, пользуется ИИ. То, о чем мы не поговорили, но очень много используется, это, конечно, политические последствия использования ИИ: системы социального рейтинга в Китае, распознавание лиц, манипулирование информацией в соцсетях, вот это, мне кажется, тема, которая играет, может быть, наиболее важную роль.

— Стоит ли людям, которые не сталкиваются в обычной жизни с этими технологиями, осваивать ChatGPT и подобного рода вещи?

Иван Стельмах: Я думаю, таких людей, которые не сталкиваются в жизни с технологией, почти нет. Вы, может быть, не замечаете, если с ней сталкиваетесь, но она вообще везде и вокруг.

Рубен Ениколопов: Это иллюзия, вы просто настолько не знаете этих технологий, что вы даже не знаете о том, что вы с ними все время сталкиваетесь. Во всяком случае люди, которые в интернете смотрят трансляции, должны понять, что они через соцсети, через поиски и так далее уже попали в эту нашу сегодняшнюю дискуссию во многом благодаря всем этим технологиям.

— Вспоминается «Социальная дилемма», документальный фильм Netflix, где одна из идей была в том, что, если ты не платишь за продукт, значит, ты и есть продукт.