Кредит доверия

Что пугает россиян при использовании ИИ

Россияне в среднем больше доверяют искусственному интеллекту (ИИ), чем жители других стран, однако среди ключевых причин недоверия по-прежнему остается непонимание механизма работы ИИ, а также желание сохранить за человеком принятие окончательных решений. Эксперты указывают, что в культурном поле искусственный интеллект связан с негативными и опасными образами, что ведет к появлению избыточных страхов, повысить же доверие можно за счет демонстрации результатов работы ИИ и внедрения нормативного регулирования, защищающего пользователей.

По данным опроса ВЦИОМа, 48% россиян доверяют искусственному интеллекту — этот показатель выше среднемирового (28%)

Фото: Анатолий Жданов, Коммерсантъ

По данным опроса ВЦИОМа, 48% россиян доверяют искусственному интеллекту — этот показатель выше среднемирового (28%)

Фото: Анатолий Жданов, Коммерсантъ

Согласно результатам опроса, проведенного Всероссийским центром изучения общественного мнения и АНО «Национальные приоритеты», 48% россиян доверяют искусственному интеллекту, не доверяют — 42%. Это означает, что в России уровень доверия населения к ИИ выше среднемирового (28%).

Среди основных причин недоверия респонденты назвали недостаточную изученность технологий ИИ, вероятность возникновения сбоев и ошибок, доверие человеку и невозможность заменить его ИИ, а также недостаточную информированность о том, как работает ИИ. Главные же причины доверия — это исключение человеческого фактора, невозможность развития без ИИ, более качественное исполнение с применением технологий, а также то, что ИИ упрощает человеку жизнь и работу, позволяет оптимизировать процессы.

В рамках исследования проводился и специальный тест, с каким животным ассоциируется ИИ: он не выявил ассоциаций с угрожающими животными, рассказала руководитель дирекции стратегии, аналитики и исследований АНО «Национальные приоритеты» Юлия Грязнова на сессии «Человек и ИИ: этика, доверие и ксенофобия». Выяснилось, что 27% опрошенных ассоциируют ИИ с собакой, 13% — с кошкой, 5% — с дельфином, 4% — с обезьяной и только 2% — с тигром. «Люди считают, что это управляемое домашнее животное»,— отметила госпожа Грязнова.

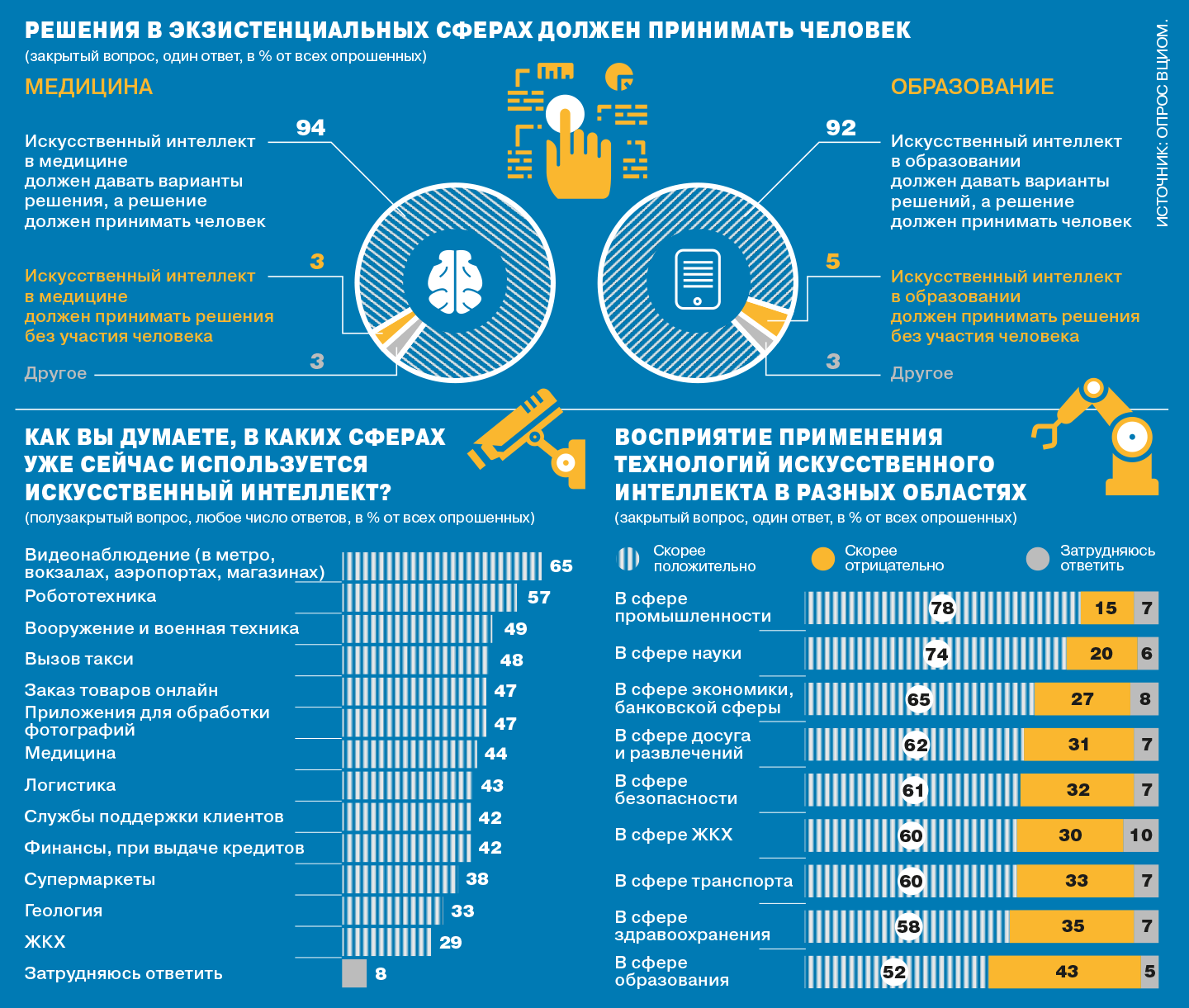

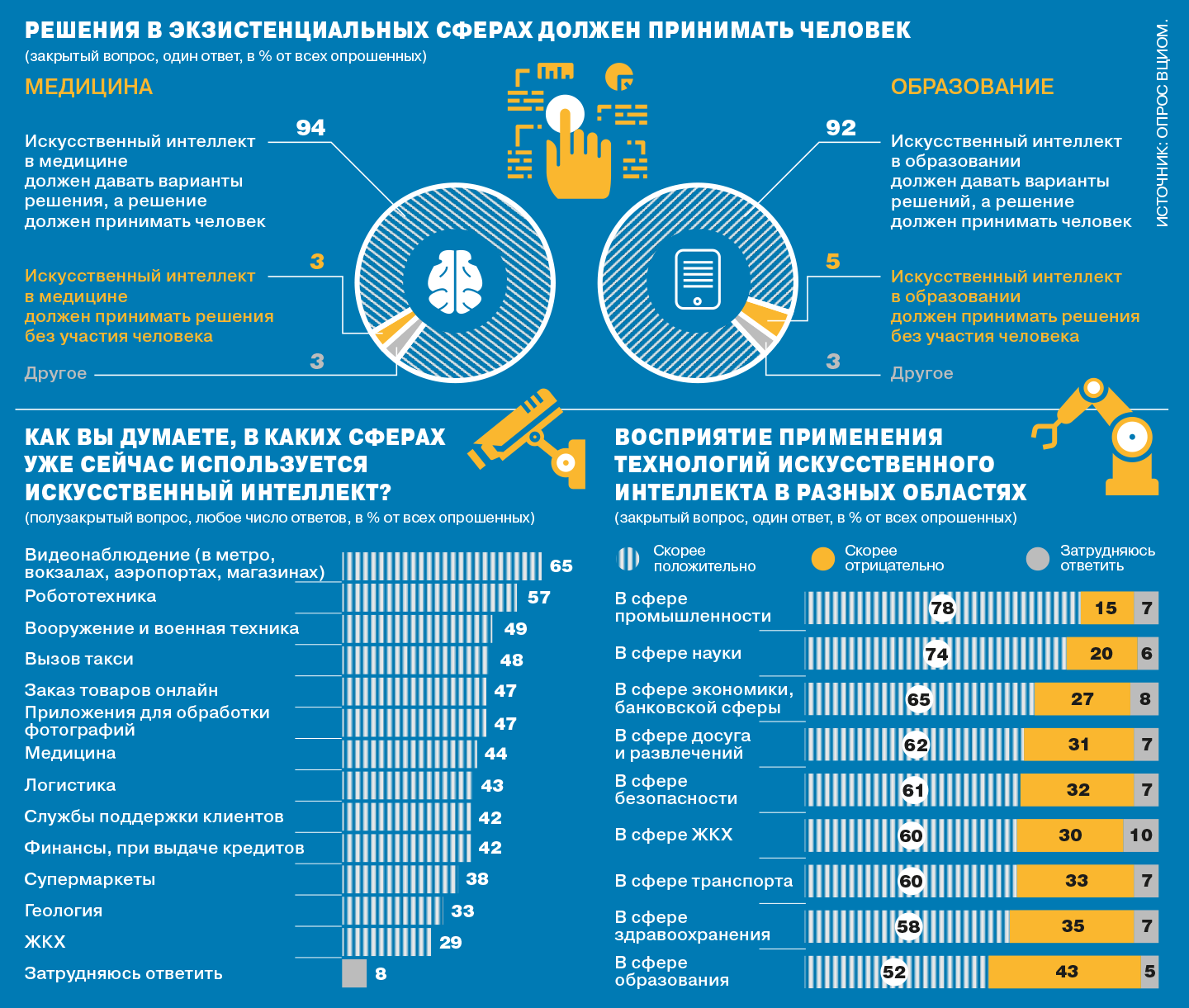

При этом исследование показало неготовность людей делегировать ИИ принятие решений, особенно в экзистенциональных сферах, таких как медицина и образование. Так, 94% опрошенных полагают, что ИИ в медицине должен давать варианты решения, а решение должен принимать человек, и лишь 3% считают, что ИИ должен принимать решения без участия человека. В сфере образования цифры оказались очень близкими — 92% и 5% соответственно. При этом, как отметила Юлия Грязнова, россияне готовы к широкому применению ИИ, например, в промышленности, в строительстве, то есть в тех сферах, которые кажутся технологичными и далекими от их жизни. Опрос показал, что с точки зрения этики от ИИ ожидают не решений, а предложения возможных вариантов, на основе которых человек примет окончательное решение, а в сфере управления от ИИ ожидают справедливости.

Управляющий директор и начальник центра исследования данных для государственных органов Сбербанка Владимир Авербах полагает, что недоверие связано с негативными образами технологий, которые присутствуют в социокультурном пространстве. «Всегда, когда происходит коммуникация, человеку необходимо создать какой-то образ в голове, и если посмотреть на образ ИИ, который создавался в фильмах, то можно вспомнить классического Терминатора или "супермозг", который управляет машинами дистанционно и обязательно его кто-то взрывает в конце фильма — понятно, что такие образы имеют мощное социокультурное воздействие, и они остаются навсегда у нас в памяти»,— пояснил господин Авербах. К тому же, когда рядом оказывается неожиданный объект, который находится вне социокультурного слоя, например железная собака, появляется напряжение из-за неизвестности того, что произойдет в следующий момент, так как в обычной жизни всегда существует какая-то предсказуемость. Изменить ситуацию, по мнению Владимира Авербаха, можно за счет создания новых, более позитивных образов, а также демонстрации реальной пользы от искусственного интеллекта — важно, чтобы люди могли связать те вещи, которые они в обыденной жизни уже и так получают, с результатами работы ИИ.

Руководитель направления регуляторной поддержки экосистемы МТС Елена Сурагина, выступая на сессии, также выделила несколько причин, по которым, по ее мнению, люди боятся ИИ. С одной стороны, страх возникает из-за непонимания ИИ как явления, с другой, напротив, из-за избыточного «сгущения красок» и демонизации технологии даже при понимании принципа ее работы. Не помогает формировать доверие и природная склонность преувеличивать опасность, а также боязнь всего неживого, эффект «зловещей долины» (когда объект, похожий внешне на человека, вызывает неприязнь и отвращение у людей-наблюдателей).

Эксперт считает, что для изменения ситуации необходимо создать объективное информационное поле, то есть говорить не только об опасностях, которые несут технологии, но и об открываемых ими новых возможностях перед человеком. Помимо этого необходима социальная ответственность бизнеса. «Важно не оставить людей один на один с неизвестностью — потребители технологии должны понимать, что, если они столкнутся с негативными явлениями, у них будет либо поддержка со стороны разработчика или продавца, либо со стороны государства»,— добавила Елена Сурагина.

Еще один важный аспект — это наличие «социально взвешенного», нормативно-правового регулирования. Здесь госпожа Сурагина привела пример машинного творчества: машина не творит, она создает некий результат алгоритмической деятельности, тогда как каждое творческое произведение индивидуально и уникально, так как в нем отражается личность человека, который его творит. Поэтому при сравнении результатов необходимо исходить из того, что это неподобные вещи. «Когда мы будем это видеть, то право уже станет не просто инструментом регулирования, но и важным инструментом доверия»,— полагает Елена Сурагина.

Главный аналитик Центра по искусственному интеллекту на базе МФТИ Игорь Пивоваров также отметил важность «мягкого» регулирования. «Нравственность — это моральные качества и правила, которыми руководствуется человек в своем выборе, из этих двух определений следует, что пока у ИИ нет "внутреннего Я", субъекта, он не делает выбор, речь идет о "слабом" ИИ. В этом смысле говорить об этике ИИ бессмысленно — она отсутствует как предмет, необходимо говорить об этике разработчика или об этике пользователя»,— добавил аналитик. «Но мы понимаем, что через какое-то время возникнет "сильный" ИИ — это будет интеллект, обладающий "внутренним Я", некоторой собственной субъектностью, который будет делать выбор»,— указал он, добавив, что ключевым критерием формирования доверия в таком случае будет предсказуемость и здесь важно появление контроля со стороны государства.

Эксперт по стратегиям и брендингу, психолог Антон Буланов также считает, что основная проблема заключается не в восприятии, чужое это или не чужое, а в понятии субъектности. «Та же самая ксенофобия возможна и к тому, кого мы считаем субъектом наших взаимоотношений»,— отметил эксперт, указав, что пока люди не готовы воспринимать ИИ как субъект. На протяжении тысячелетий человек воспринимал субъектом только другого человека, то есть на подсознательном уровне для людей на протяжении еще долгого времени за ИИ кто-то будет стоять: или его разработчик, или «человек, который сидит за пультом и нажимает на кнопки», или кто-то, кто владеет системой ИИ. Кроме того, эксперт полагает, что понимание доверия к ИИ невозможно без представления о доверии в обществе. «Если общий уровень доверия граждан друг к другу, к государству, к институтам довольно низкий, то он вряд ли будет высоким и по отношению к искусственному интеллекту»,— указал Антон Буланов.

Однако массовое изменение отношения к ИИ может и не потребовать столь долгого времени. Директор по развитию технологий искусственного интеллекта «Яндекса» Александр Крайнов считает, что баланс между доверием и недоверием к ИИ вскоре изменится настолько, что говорить об этом уже не придется. В будущем, по его мнению, к этой технологии перестанут относиться как к чему-то невероятному, сакральному. «Когда наконец наступит понимание, что это такое, все страхи уйдут, причем это произойдет не потому, что все прозрели, а из-за естественной смены поколений — если посмотреть на детей, у них такой проблемы с ИИ нет. Они очень хорошо интуитивно понимают, что это такое»,— отметил он. При этом эксперт указал на неизбежность кризисов в доверии людей к ИИ, так как по мере внедрения технологии будут появляться ошибки. «Какие-то инциденты, безусловно, будут, и в этот момент никто не будет вспоминать, насколько сократилась аварийность или насколько в целом в медицине сократилось количество неверных диагнозов. Будут каждый раз вспоминать именно одно плохое происшествие»,— предупредил Александр Крайнов.