Страсти по поводу форсированного реформирования Академии наук вроде бы улеглись — законопроект на этот счет "отъехал" на осень. Но дискуссия о том, как измерить эффективность работы ученых, никуда не делась. Для чиновников все свелось к рейтингам в индексах цитируемости: на них основаны все претензии к ученым. "Огонек" пытался понять, поправимо ли дело

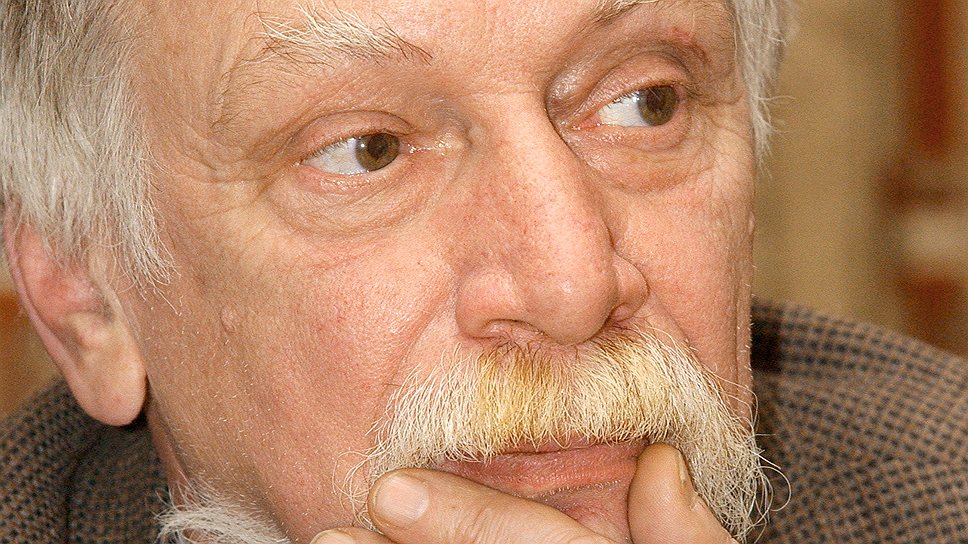

Александр Антопольский, профессор кафедры прикладной информатики

Фото: Фото ИТАР-ТАСС

Помимо освобождения ученых от бремени управления академической собственностью реформа Академии наук в представленном широкой публике варианте преследует вполне благие цели. Среди прочего это повышение престижа в глазах мирового сообщества, увеличение числа публикаций в западных научных журналах, а также введение загадочного для непосвященных индекса Хирша в качестве главного критерия эффективности работы ученого.

Кто и по каким правилам составляет "рейтинги успеваемости", от которых теперь, похоже, будут зависеть судьбы научных институтов, вузов, а также карьеры десятков тысяч людей? И почему чиновники так настаивают на внедрении в науку рейтинговой "табели о рангах"?

Об этом "Огонек" поговорил с одним из ведущих российских специалистов в области наукометрии Александром Антопольским.

— Министр образования и науки Дмитрий Ливанов озвучил грустную цифру: Российская академия наук по международным рейтингам занимает всего лишь 193-е место в мире...

— Я бы с большой осторожностью рекомендовал относиться ко всем этим цифрам, потому что в мире есть множество разных рейтингов, а это дает большой простор для манипулирования общественным мнением.

— Тем не менее слабая публикационная активность российских ученых стала предметом пристального внимания даже первых лиц государства. Так, в указе президента России "О мерах по реализации государственной политики в области образования и науки" поставлена задача к 2015 году добиться увеличения доли публикаций российских исследователей в мировых научных журналах, индексируемых в базе данных Web of Science, до 2,44 процента. Сейчас же доля наших публикаций, по данным "Российской газеты", не превышает 1,68 процента. Чем объяснить столь слабое представительство российской науки в этих индексах цитирования?

— Для начала стоит понять, как появились эти рейтинги. Web of Science — старейший, самый знаменитый индекс цитирования. Придумал его в 1960-х Юджин Гарфильд, основатель всей современной системы библиометрии. Он создал целый Институт научной информации США, причем сделал его в совершенно некоммерческих целях. Кстати, сам Гарфильд сегодня активно протестует против использования его изобретения для управленческих целей — с конца 1990-х без упоминания его индекса Web of Science в резюме ученому на Западе стало невозможно устроиться на работу. Протесты Гарфильда поддерживают и многие другие ученые, но все это бесполезно: уж больно удобным оказался сам инструмент для чиновников и управленцев, контролирующих финансирование научных исследований.

Так вот, когда его институт перешел под контроль медиакорпорации Thomson Reuters, то в Сети была создана поисковая платформа Web of Knowledge, под крышей которой объединились самые различные базы данных, в том числе и по публикациям в научных журналах. Внутри этой платформы есть база данных Web of Science, объединяющая 12 тысяч журналов по естественным и гуманитарным наукам. Именно на основе этой информационной базы и происходит подсчет индекса цитирования каждого автора, публикующегося на страницах научных изданий, входящих в базу. В основном это, конечно, англоязычные журналы.

— Вы хотите сказать, что во всем виноват языковой барьер?

— Не только, ведь в Web of Science индексируются и немецкие, и японские, и китайские журналы. Но стоит понимать, что Thomson Reuters — это все-таки коммерческая компания и за идею они работать не будут. У них все материалы распространяются по подписке, и эта подписка стоит недешево — 2-3 тысячи долларов в год. И когда от России в их системе числится всего 20-30 подписчиков, им неинтересно работать с российскими базами данных. Вот если, говорят они, у нас была хотя бы пара тысяч подписчиков, то мы бы взялись.

— Получается, что увеличить долю российских публикаций в базе данных Web of Science можно без всяких реформ, просто подписав на Web of Science каждый российский вуз и научный институт?

— Проблема в том, что нет внятной информационной стратегии. Власть реагирует только на сиюминутные вызовы времени, но не в силах сформировать собственную повестку дня. И ни правительство, ни руководство Академии наук в упор не видят всех информационных потребностей российской науки.

— Почему мы добиваемся увеличения российского рейтинга именно в Web of Science? Есть ведь и другие индексы цитируемости.

— Конечно. Вторая система — Scopus, созданная голландской издательской корпорацией Elsevier, которая и сама издает свыше 3 тысяч научных журналов и отслеживает практически все журналы по различным отраслям науки в мире. Но пробиться туда российским журналам тоже непросто, для этого нужен рост числа подписчиков, а у российских вузов на это нет средств. Россия — не первая держава, которая обнаружила "дискриминацию" в международных рейтингах. До этого были, например, Япония и Китай, потом латиноамериканцы и арабы, которые тоже создавали свои собственные индексы. И, кстати, искусственная стимуляция публикационной активности — это в чем-то и полезная вещь, потому что и сами ученые начинают шевелиться, и исследования стали проводить быстрее — в общем, как ни крути, а положительный эффект был отмечен.

— Ну а вот вы сами свой личный индекс Хирша знаете? Если да, то что дает это знание лично вам — реально ли, скажем, понять на основе этого индекса, хороший вы ученый или нет?

— Ну, мой личный индекс Хирша, согласно данным Российского индекса научного цитирования (РИНЦ), составляет 4. Это немного, но для ученого моего направления неплохо...

Наверное, говорить надо о другом. Библиометрия, то есть оценка специализированных информационных массивов как наукометрический метод, традиционно основывалась на анализе двух показателей. Первый — это количество документов, которые принадлежат тому или иному автору. Второй — это влияние каждого документа, его ценность, которую можно измерить через цитируемость: чем больше документ цитируется, тем он считается более важным.

Все эти методики были разработаны еще в середине прошлого века и до недавних пор воспринимались как некие вспомогательные инструменты в сугубо научных дискуссиях. Но с начала нового тысячелетия, когда во всем мире был взят курс на инновационную экономику, предполагающую быструю отдачу вложенных в науку финансовых средств, ситуация кардинально поменялась и вспомогательные методы стали главными. Грубо говоря, в науку пришли управленцы, бухгалтеры и менеджеры, которым были нужны инструменты оценки научных исследований, чтобы на их основе строить принцип финансирования науки. Хороший у тебя показатель — дадим денег, плохой — не дадим.

Разумеется, внедрение подобных методик вызвало большие дискуссии, потому что идеальных способов оценки нет — у любого наукометрического метода есть свои плюсы и свои минусы. Подытожить все эти дискуссии можно так: никто не отрицает в целом необходимости объективных измерений эффективности тех или иных вложений в науку, но методы формального математического анализа должны дополняться и экспертными содержательными оценками.

— Так в чем же достоинства научных рейтингов и самого популярного из них, составленного по методике Хорхе Хирша?

— Начнем с проблемы. При попытках создать какую-либо методику подсчета цитируемости неизбежно возникают вопросы о частных случаях. Ну, например, как оценивать рейтинг секретных ученых, работающих на оборонную отрасль? Или как быть с теми, кто по своей натуре не может выдавать на-гора по статье в месяц, но долго вынашивает собранный материал? Например, у французского математика Эвариста Галуа был бы совершенно мизерный показатель публикационной активности, он за всю свою жизнь опубликовал всего три статьи, но при этом Галуа стал основателем совершенно новой науки — высшей алгебры.

Непростой вопрос и контекст цитирования. Как оценить, например, критические замечания на "труды" какого-нибудь очередного Петрика — это тоже цитирование или все-таки нет? А как быть с тем фактом, что самым цитируемым российским ученым является один наш молодой физик, работающий на Большом адронном коллайдере в CERN? Он вошел в число авторов справочника по ядерным константам, поэтому его имя автоматом упоминается при любой публикации, где речь идет об экспериментах на коллайдере.

Словом, при вычислении отношения общего числа цитирования к общему числу публикаций возникает такое количество исключений, что все подсчеты делаются бессмысленными. А вот индекс Хирша находит некий баланс между всеми крайностями и дает очень взвешенный результат, не предоставляя при этом никому очевидных преимуществ — ни маститым ученым, ни директорам институтов, ни аспирантам. Кроме того, преимущество метода Хирша и в том, что обилие мало цитируемых публикаций никак не влияет на расчеты, которые получены с его помощью. Поэтому нет никакого смысла искусственно "надувать" количество публикаций, отправляя в печать пустые статьи.

— А в чем тогда недостатки этого индекса?

— "Хирш" может применяться к оценке любого ученого, работающего в любой области науки, но он совершенно не пригоден для сравнения эффективности исследований в разных научных областях. По уровню цитируемости нельзя сравнивать биолога с математиком. Или философа с химиком. Даже биолога с биологом сравнивать нельзя, потому что уровень цитируемости работ любого генетика отличается от цитируемости вирусолога.

Тем не менее у чиновников от науки соблазн сравнивать результативность, если можно так выразиться, ученых не пройдет никогда. Хуже того, широкое внедрение наукометрических методик ведет к тому, что появляются приемы искусственного наращивания цитируемости и даже ноу-хау, "как починить рейтинг". Вот, к примеру, не так давно вспыхнул скандал, когда пять китайских университетов были изобличены в сговоре взаимного цитирования. То есть они договорились между собой и цитировали друг друга в большом количестве, надувая друг другу рейтинги. Но их довольно быстро поймали за руку — сегодня созданы компьютерные программы, которые выявляют все эти замкнутые циклы цитирования, случаи самоцитирования, цитирования внутри одного журнала или одного научного института.

— Пожалуй, самый важный вопрос: а кто проводит расчеты этих самых публикаций и цитирования? Кто эти люди? И откуда вообще ученые узнают свой персональный индекс Хирша?

— Любой российский ученый может узнать свой индекс Хирша на сайте РИНЦ — Российского индекса научного цитирования. Напомню, что РИНЦ — это национальная информационно-аналитическая система, созданная в 2005 году по результатам специального конкурса Министерства образования и науки России. Конкурс выиграла компания "Научная электронная библиотека", она же сделала электронную библиотеку в интернете, где индексируются публикации из 4 тысяч иностранных и 2,3 тысячи отечественных научных журналов — собственно, на базе этой библиотеки и проходит вычисление показателей РИНЦ.

Теперь о доверии к тем, кто занимается индексированием публикаций. Вопрос этот ключевой в наукометрии, но пока что этого доверия, мягко говоря, дефицит. Почему? В базе данных РИНЦ много алгоритмических и лингвистических ошибок. Есть трудности "перевода" — например, одной и той же фамилии с разных языков. Программа индексирования практически не умеет различать однофамильцев, не учитывает, что одна и та же организация может по-разному называться, что есть сокращенные и полные названия. В общем, вопросов хватает. И один из них принципиальный: если в мире индексы цитирования производят несколько компаний, то в России другого индекса нет.

— Все ли российские ученые представлены в базе данных РИНЦ?

— Нет, конечно. Недавно я проводил исследования по уровню цитируемости академиков Российской академии образования. Выяснилось: из 250 академиков и членов-корреспондентов в базе данных РИНЦ отражены не более половины. Еще несколько цифр: РИНЦ охватывает более 2 тысяч российских научных журналов, а их издается более 4 тысяч — чуть ли не каждый факультет и каждая кафедра в вузе издают свой журнал. Кроме того, в базе данных не учитываются труды конференций, изданные научные сборники, монографии, методички, а все эти издания сегодня очень важны.

— Есть мнение, что российские ученые вообще не очень любят публиковать статьи о своей работе...

— Это, мягко говоря, не совсем достоверная информация. Наши ученые всегда публиковались. В том числе и за рубежом в самых престижных журналах. Скажу больше: многие наши ученые, особенно те, кто работает в области естественных наук, давно научились использовать эту систему в своих интересах. Например, у меня есть знакомый академик, который в России уже лет 10 не публикуется. Только за рубежом.

P.S. Редакция "Огонька" благодарит руководство ИНИОН РАН и Юрия Черного за помощь в организации интервью.

"От научного информбюро"

Визитная карточка

Журнальной полосы не хватит для того, чтобы перечислить все регалии профессора Антопольского. Достаточно сказать, что именно Александр Борисович в 1960-е стоял у истоков создания ГСНТИ (Государственной системы научной и технической информации) — бумажного "интернета", благодаря которому каждый технический институт и вуз в СССР могли ориентироваться в мировом информационном потоке и получать доступ к нужной технической документации. Позже он работал во Всесоюзном институте научной и технической информации АН СССР — крупнейшем "мозговом центре" советской науки. В 1990-е Антопольский стал основателем и первым директором НТЦ "Информрегистр" — госсистемы мониторинга научного информационного пространства. Далее занялся созданием Российской ассоциации электронных библиотек, сегодня он работает в Институте научной и педагогической информации РАО и сотрудничает с Институтом научной информации по общественным наукам (ИНИОН) РАН. Также Александр Борисович преподает — он профессор кафедры прикладной информатики Московского государственного университета культуры и искусств.