Постепенное освоение искусственного интеллекта, появление умных вещей и роботов, способных обучаться, заставляют людей все чаще задумываться о последствиях использования этих технологий. Пока власти стран не слишком вовлечены в тему, однако специалисты призывают как можно скорее заняться разработкой свода правил, который бы регулировал данную сферу. Потому что будущее, где роботы сосуществуют с людьми, уже давно наступило.

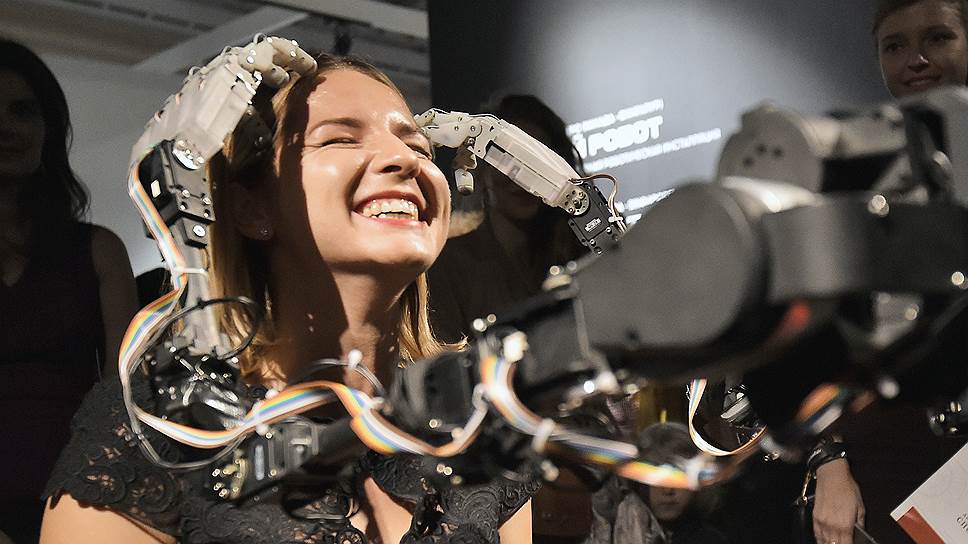

Фото: Ирина Бужор, Коммерсантъ / купить фото

В последнее время все чаще встречаются новости о том, что программа или робот, оснащенные технологией самообучения, повели себя в реальной жизни не так, как предполагалось при написании программного кода. Последствия сильно разнятся по степени вреда, однако эти случаи поднимают несколько важных вопросов, касающихся сферы регулирования искусственного интеллекта.

Например, кто должен нести ответственность за «проступки» роботов — производители, программисты или пользователи?

Или это будут сами роботы, которые в будущем должны получить полноценный искусственный интеллект и стать альтернативой людям? И до какой степени роботы должны быть самостоятельными?

Действующее законодательство в разных странах пока не готово ответить ни на один из этих вопросов. Профессор права в Университете Вашингтона Райан Кало полагает, что человечеству давно пора определиться с регулированием: «В 1920-е, 40-е, 80-е или в 2017 году, представляя будущее, люди думают в первую очередь о роботах. Но реальность такова, что роботы сосуществуют с нами еще с 1950-х годов». Однако суды, сталкиваясь на протяжении вот уже нескольких десятилетий с различными делами, в которые вовлечены роботы в самом широком смысле этого слова, до сих пор не могут адекватно подойти к их разрешению. Проблема в том, что у судей зачастую очень искаженное и устаревшее представление о технологиях. «Роботы ставят перед судами уникальные юридические задачки, которые судьи просто не в состоянии решить»,— подытоживает профессор Кало в интервью Financial Times.

Фантасты приучили людей к тому, что вышедший из-под контроля искусственный интеллект — это машины, которые однажды разозлились на людей и начали бездушно уничтожать человечество. На деле все куда сложнее. Например, основатель Tesla и SpaceX Илон Маск, говоривший об угрозе искусственного интеллекта в середине июля, привел в пример чат-ботов. «Роботы могут начать войну, выпуская фейковые новости и пресс-релизы, подделывая учетные записи электронной почты и манипулируя информацией. Перо сильнее меча»,— заявил тогда предприниматель. И как уже писал “Ъ”, первыми роботами, ослушавшимися человека, действительно стали безобидные на первый взгляд программы. Это и совсем не патриотичные чат-боты китайского мессенджера Tencent QQ, и боты Microsoft — Tay и пришедший ему на смену Zo. Некоторые создатели таких ботов предусмотрительно задают им ограничения, например, не позволяя общаться на тему политики или религии, как это сделал тот же Microsoft. Но, как показывает практика, самообучающиеся боты копируют у людей все повадки и выражения и через какое-то время начинают выходить за рамки дозволенного.

Излишне болтливые чат-боты и даже те, что выпускают фейковые новости, не самая большая беда для человечества. Последствия неправильной (не предусмотренной создателями) работы искусственного интеллекта могут быть куда страшнее. Один из ярких примеров такого сбоя — авария с участием автомобиля Tesla во Флориде, случившаяся год назад из-за того, что система автопилота «не разглядела» выехавшую на проезжую часть фуру и автомобиль на полном ходу влетел в прицеп. Водитель погиб на месте. Власти не стали наказывать компанию за просчет автопилота и отзывать автомобили, сочтя, что это был единичный сбой системы. В итоге Национальное управление по безопасности движения транспорта США (NHTSA) предписало Tesla более доходчиво объяснять водителям, что система автопилота компании не является самодостаточным автопилотом и может служить лишь помощником при вождении. Никаких законодательно закрепленных нормативов для самоуправляемых автомобилей в большинстве юрисдикций по-прежнему не существует.

Перспектива создания роботов с искусственным интеллектом, очевидно, должна волновать регуляторов с точки зрения безопасности. И речь идет не о взбесившихся роботах, которые однажды могут взять в руки оружие, как в «Терминаторе». Вызывают беспокойство вообще все вооруженные роботы. Многие эксперты в области искусственного интеллекта уверены, что машинам нельзя давать в руки оружие и уж тем более ставить их на службу армии. Так, более 100 специалистов, в том числе вышеупомянутый Илон Маск, призвали ООН запретить разработку и использование автономного оружия. «Если смертоносное автономное оружие будет создано, оно позволит вооруженному конфликту достигнуть невиданных масштабов, и справиться с темпами развития ситуации людям будет не под силу,— говорится в письме.— Эти разработки могут стать орудием террора, которое деспоты и террористы применяют против ни в чем не повинных людей, а хакеры смогут взламывать для использования в недопустимых целях».

Наконец, даже у самого совершенного искусственного интеллекта, скорее всего, будут повадки и модель поведения человека. Если это будут и не роботы-гуманоиды, самостоятельно принимать решения они будут, основываясь на базе знаний и умений, которыми овладеют, изучая само человечество. В таком случае стирается последняя грань между роботами и людьми. В науке появилась отдельная сфера исследований взаимодействий людей и роботов. Одной из главных проблем, связанных с ними, становится применение этических и моральных норм, присущих человеку, к роботам. «С точки зрения юриспруденции и морали, роботы — это машины, запрограммированные и созданные людьми,— отмечает профессор Института робототехники в Университете Карнеги-Меллон Хэнни Адмони.—

Но мы же хотим, чтобы роботы действовали самостоятельно. Мы хотим, чтобы роботы сами могли принимать решения в новых для себя ситуациях.

И теперь обсуждение проблемы невозможно без рассмотрения этического аспекта, потому что теперь роботы могут действовать независимо от человека».